Apple Glass可以通过仅渲染用户注视的内容来加速AR

通过使用注视来确定要分析的摄像头元素的优先级,分析用户正在看的内容可能有助于Apple Glass或AR头戴式耳机改善其在处理视频方面的性能。

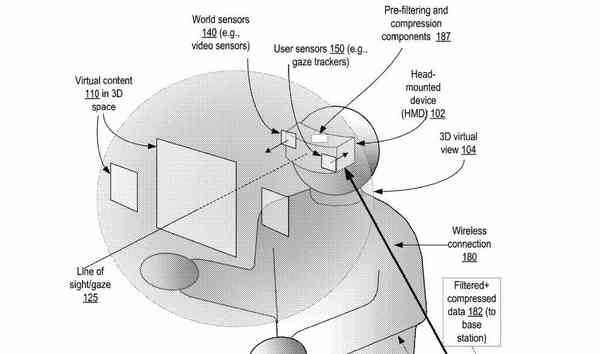

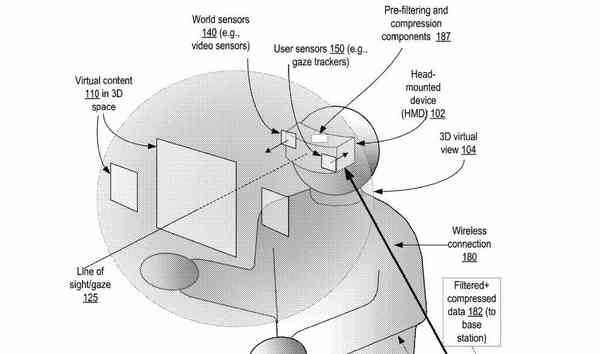

增强现实系统依赖于收集有关环境的数据,以便更好地向用户提供混合现实图像。对于大多数人来说,这主要归结为从用户的眼睛附近获取实时的摄像头馈送,对其进行数字化处理,然后以更改后的状态向用户展示,尽管这也可以涵盖深度映射等其他数据类型。

由于许多VR和AR系统使用与主机捆绑在一起的头戴式耳机,因此需要输入有关环境的数据可能会导致问题,因为一次只能通过这么多的数据来传送数据。多年来对相机的改进,包括更高的分辨率和帧速率,意味着有更多的数据需要分析和处理,并且可能束缚不了。

还有更多的处理资源需要考虑,因为数据越多,创建AR图像所需的处理就越多。

美国专利商标局授予的一项名为“基于凝视方向的视频数据自适应预过滤”的专利中,Apple试图通过缩小需要处理的视频数据的范围来解决入侵问题。处理发生。

简而言之,该专利建议该头戴式受话器可以拍摄环境图像,并对场景应用一些过滤器,每个过滤器覆盖视频帧的不同区域。这些过滤器根据用户的目光以及典型的AR和VR数据点(如头部位置和动作)来确定要发送给主机进行处理的数据的位置。

过滤后的数据层通过系绳或无线方式发送到主机,然后进行处理并反馈到耳机进行显示。然后循环重复。

其背后的逻辑是,处理用户实际看到的内容并不一定需要照相机采集的所有数据。当用户可能面对一个方向时,他们的眼睛可能会指向一侧,从而使内容在其视图的另一侧的呈现实际上毫无意义。

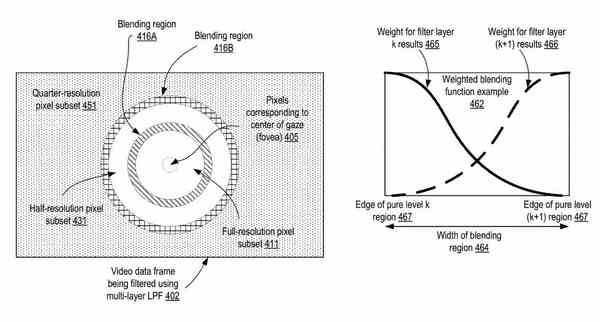

苹果的系统需要检测到注视,然后将该数据点应用于图像数据帧。数据的多个子集可以定义可以优先处理的图像的各种形状和大小,用户可以在主要子集下积极查看各个部分,而较大的辅助版本可以覆盖周围区域。

由于较小的主要子集被用户主动查看,因此它们将被赋予处理优先级。次宽的子集由于位于用户外围而可能需要较少的处理,因此重要性不大。由于该次要数据不如优先级数据子集那么重要,因此也可能不会以完整质量发送给主机。

在为用户渲染最终图像时,数据可以应用其他过滤器,以尽可能不引人注目的方式将它们有效地结合在一起。实际上,系统会模糊主要的高质量子集和较低质量的外围子集之间的线,并且其余的相机供稿会覆盖在AR应用程序中。

![]()

用户注视的中心将被完全渲染,而较低质量的渲染将更远。

子集标识不一定必须一次性生成。苹果公司建议,有可能在摄像机生成第一帧视觉数据之后创建主要子集,但可以在创建第二帧期间确定次要子集区域。

此外,与第二帧相关联的凝视检测数据可以通知第一帧中的次要子集区域以进行处理。这对于用户的眼睛在移动的情况很有用,因为这可以减轻用户的视点变化的任何不希望的影响,以及系统必须在其视场中捕捉并放置数据。

该专利将其发明人列为Can Jin,Nicholas Pierre Marie Frederic Bonnier和Hao Pan。它最初于2018年7月19日提交。

Apple每周都会提交大量专利申请,但是尽管存在的专利申请表明Apple的研究与开发领域是其关注的领域,但它们不能保证在未来的产品或服务中使用它们。

有传言称,苹果从事某种形式的AR或VR头戴式耳机已有多年的历史,最近的大多数猜测都围绕着所谓的“ Apple Glass”。谣言被认为有可能采用AR头戴式耳机的形式,随后可能还会采用智能眼镜,谣言暗示它可能采用尺寸与典型眼镜相似的眼镜。

当然,苹果公司已经提交了许多与该领域相关的专利申请,但是在核心概念上非常相似的一个是从2019年6月开始的“ Fovated Display ”。在该申请中,苹果公司提出了一种改善处理和处理的方法。通过限制正在处理的数据量来实现耳机显示器的渲染性能。

归档并不仅仅是限制数据到达主机设备,而是将数据发送到显示器。苹果公司以类似于数据子集的方式,建议显示器可以使用两种不同的数据流,包括高分辨率和低分辨率图像。

使用凝视检测,系统将仅在用户正在观看的位置放置高分辨率图像,然后再放置周围区域的较低分辨率数据。通过这样做,显示器本身具有更少的数据,在更新每次刷新时必须处理,这可以允许使用更高的刷新率。