在Ubuntu 20.04 LTS Focal Fossa上安装Apache Hadoop

在Ubuntu 20.04 LTS Focal Fossa上安装Apache Hadoop

步骤1.首先,通过apt在终端中运行以下命令来确保所有系统软件包都是最新的。

sudo apt update sudo apt upgrade

步骤2.安装Java。

为了运行Hadoop,您需要在计算机上安装Java 8。为此,请使用以下命令:

sudo apt install default-jdk default-jredefault-jdk default-jre

安装后,您可以使用以下命令来验证Java的安装版本:

java -version-version

步骤3.创建Hadoop用户。

首先,使用以下命令创建一个名为Hadoop的新用户:

sudo addgroup hadoopgroup sudo adduser —ingroup hadoopgroup hadoopuser—ingroup hadoopgroup hadoopuser

接下来,使用Hadoop用户登录并使用以下命令生成SSH密钥对:

su - hadoopuser- hadoopuser ssh-keygen -t rsa-keygen -t rsa cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys chmod 0600 ~/.ssh/authorized_keys0600 ~/.ssh/authorized_keys

之后,使用以下命令验证无密码的SSH:

ssh localhost

在没有密码的情况下登录后,可以继续执行下一步。

步骤4.在Ubuntu 20.04上安装Apache Hadoop。

现在,我们下载Apache Hadoop的最新稳定版本,在撰写本文时,它是版本3.3.0:

su - hadoop- hadoop wget https://downloads.apache.org/hadoop/common/hadoop-3.3.0/hadoop-3.3.0.tar.gz://downloads.apache.org/hadoop/common/hadoop-3.3.0/hadoop-3.3.0.tar.gz tar -xvzf hadoop-3.3.0.tar.gz-xvzf hadoop-3.3.0.tar.gz

接下来,将提取的目录移至:/usr/local/

sudo mv hadoop-3.3.0 /usr/local/hadoop-3.3.0 /usr/local/hadoop sudo mkdir /usr/local/hadoop/logs/usr/local/hadoop/logs

我们将Hadoop目录的所有权更改为Hadoop:

sudo chown -R hadoop:hadoop /usr/local/hadoop-R hadoop:hadoop /usr/local/hadoop

步骤5.配置Apache Hadoop。

设置环境变量。编辑文件,并在文件末尾附加以下值:~/.bashrc

nano ~/.bashrc~/.bashrc

添加以下行:

export HADOOP_HOME=/usr/local/hadoop HADOOP_HOME=/usr/local/hadoop export HADOOP_INSTALL=$HADOOP_HOMEexport HADOOP_INSTALL=$HADOOP_HOME export HADOOP_MAPRED_HOME=$HADOOP_HOMEexport HADOOP_MAPRED_HOME=$HADOOP_HOME export HADOOP_COMMON_HOME=$HADOOP_HOMEexport HADOOP_COMMON_HOME=$HADOOP_HOME export HADOOP_HDFS_HOME=$HADOOP_HOMEexport HADOOP_HDFS_HOME=$HADOOP_HOME export YARN_HOME=$HADOOP_HOMEexport YARN_HOME=$HADOOP_HOME export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/nativeexport HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native export PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/binexport PATH=$PATH:$HADOOP_HOME/sbin:$HADOOP_HOME/bin export HADOOP_OPTS=\"-Djava.library.path=$HADOOP_HOME/lib/native\"export HADOOP_OPTS=\"-Djava.library.path=$HADOOP_HOME/lib/native\"

将环境变量应用于当前正在运行的会话:

source ~/.bashrc~/.bashrc

接下来,您将需要在其中定义Java环境变量来配置YARN,HDFS,MapReduce和Hadoop相关的项目设置:hadoop-env.sh

sudo nano $HADOOP_HOME/etc/hadoop/hadoop-env.sh/etc/hadoop/hadoop-env.sh

添加以下行:

export JAVA_HOME=/usr/lib/jvm/java-11-openjdk-amd64 JAVA_HOME=/usr/lib/jvm/java-11-openjdk-amd64 export HADOOP_CLASSPATH+=\" $HADOOP_HOME/lib/*.jar\"export HADOOP_CLASSPATH+=\" $HADOOP_HOME/lib/*.jar\"

现在,您可以使用以下命令来验证Hadoop版本:

hadoop version

步骤6.配置文件。core-site.xml

在文本编辑器中打开文件:core-site.xml

sudo nano $HADOOP_HOME/etc/hadoop/core-site.xml/etc/hadoop/core-site.xml

添加以下行:

fs.default.name fs.default.name hdfs://0.0.0.0:9000 hdfs://0.0.0.0:9000 The default file system URI The default file system URI

步骤7.配置文件。hdfs-site.xml

使用以下命令打开文件进行编辑:hdfs-site.xml

sudo nano $HADOOP_HOME/etc/hadoop/hdfs-site.xml/etc/hadoop/hdfs-site.xml

添加以下行:

dfs.replication dfs.replication 1 1 dfs.name.dir dfs.name.dir file:///home/hadoop/hdfs/namenode file:///home/hadoop/hdfs/namenode dfs.data.dir dfs.data.dir file:///home/hadoop/hdfs/datanode file:///home/hadoop/hdfs/datanode

步骤8.配置文件。mapred-site.xml

使用以下命令访问文件:mapred-site.xml

sudo nano $HADOOP_HOME/etc/hadoop/mapred-site.xml/etc/hadoop/mapred-site.xml

添加以下行:

mapreduce.framework.name mapreduce.framework.name yarn yarn

步骤9.配置文件。yarn-site.xml

在文本编辑器中打开文件:yarn-site.xml

sudo nano $HADOOP_HOME/etc/hadoop/yarn-site.xml/etc/hadoop/yarn-site.xml

添加以下行:

yarn.nodemanager.aux-services yarn.nodemanager.aux-services mapreduce_shuffle mapreduce_shuffle

步骤10.格式化HDFS NameNode。

现在,我们以Hadoop用户身份登录,并使用以下命令格式化HDFS NameNode:

su - hadoop- hadoop hdfs namenode -format-format

步骤11.启动Hadoop集群。

现在,使用以下命令启动NameNode和DataNode:

start-dfs.sh-dfs.sh

然后,启动YARN资源和节点管理器:

start-yarn.sh-yarn.sh

您应该观察输出,以确保它尝试一一启动从属节点上的datanode。要使用\’ jps\’命令检查所有服务是否正常启动:

jps

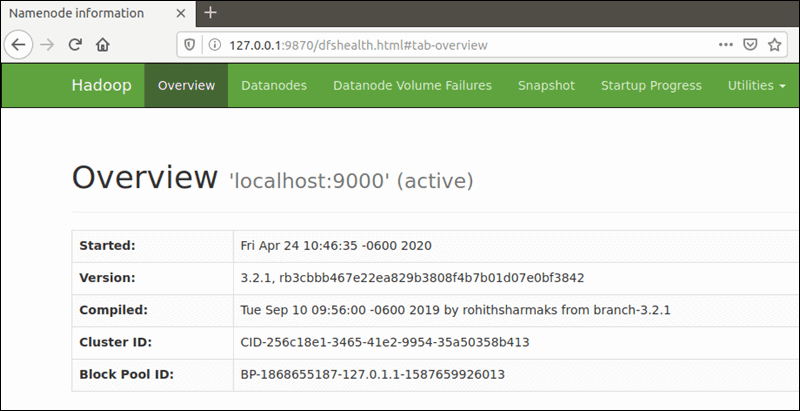

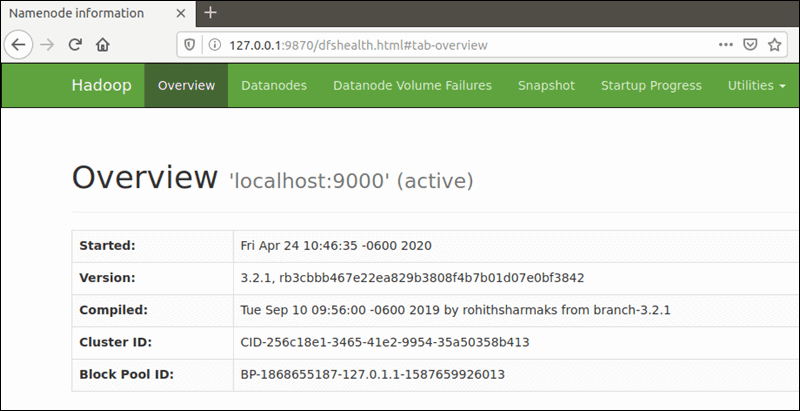

步骤12.访问Apache Hadoop。

默认端口号9870使您可以访问Hadoop NameNode UI:

http://your-server-ip:9870://your-server-ip:9870

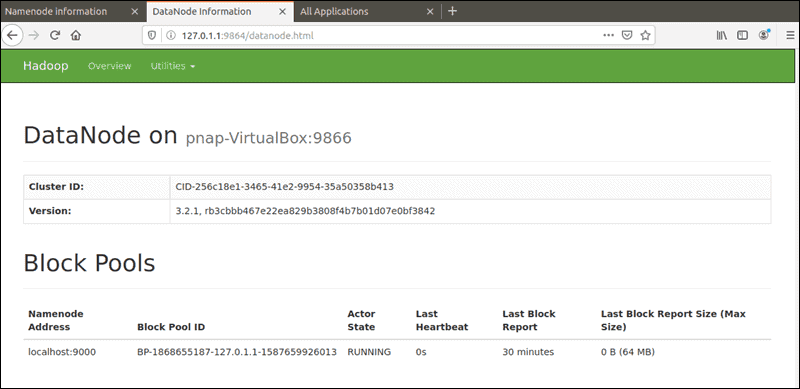

默认端口9864用于直接从浏览器访问单个DataNode:

http://your-server-ip:9864://your-server-ip:9864

![]()

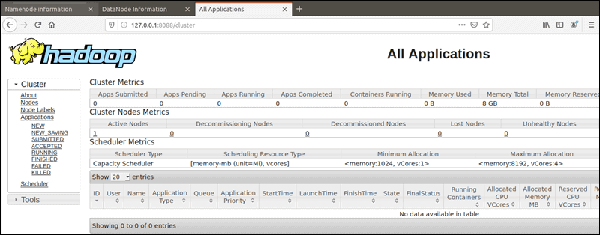

YARN资源管理器可在端口8088上访问:

http://your-server-ip:8088://your-server-ip:8088

![]()

恭喜你!您已经成功安装了Hadoop。使用本教程在Ubuntu 20.04 LTS Focal Fossa系统上安装Apache Hadoop。有关其他帮助或有用信息,我们建议您检查Apache Hadoop官方网站。